Статья опубликована в рамках: LIII Международной научно-практической конференции «Инновации в науке» (Россия, г. Новосибирск, 27 января 2016 г.)

Наука: Информационные технологии

Скачать книгу(-и): Сборник статей конференции часть 1, Сборник статей конференции часть 2

дипломов

Статья опубликована в рамках:

Выходные данные сборника:

РЕЖИМЫ ОБУЧЕНИЯ В ИСКУССТВЕННЫХ НЕЙРОННЫХ СЕТЯХ

Мелихова Оксана Аскольдовна

канд. техн. наук, доц., доц. Южного федерального университета,

РФ, г. Таганрог

Вепринцева Ольга Витальевна

студент Южного федерального университета,

РФ, г. Таганрог

" target="_blank">amime_ame4@mail.ru

Чумичев Владимир Сергеевич

студент Южного федерального университета,

РФ, г. Таганрог

E-mail: vladimir.chumichev@mail.ru

Джамбинов Сергей Владимирович

студент Южного федерального университета,

РФ, г. Таганрог

Гайдуков Анатолий Борисович

студент Южного федерального университета,

РФ, г. Таганрог

MODES OF LEARNING IN ARTIFICIAL NEURAL NETWORKS

Oksana Melikhova

candidate of Science, assistant professor,

assistant professor of the Southern Federal University,

Russia, Taganrog

Olga Veprintseva

student of the Southern Federal University,

Russia, Taganrog

Vladimir Chumichev

student of the Southern Federal University,

Russia, Taganrog

Sergey Dzhambinov

student of the Southern Federal University,

Russia, Taganrog

Anatoly Gaidukov

student of the Southern Federal University,

Russia, Taganrog

АННОТАЦИЯ

При выборе структуры нейронной сети возникает проблема предварительной оценки её уровня интеллектуальности. Для большинства приложений основными критериями интеллектуальности сетей служит её способность к обучению. В работе приводится один из наиболее исследованных способов обучения нейронных сетей – метод обратного распространения ошибок. Кроме того, приводится сравнение последовательного и пакетного режимов обучения для многослойной искусственной нейросети.

ABSTRACT

When selecting the structure of the neural network is a problem of its preliminary assessment of the level of intelligence. For most applications, the main criteria of intelligent networks is its ability to learn. The work is one of the most studied methods of training neural network – a method of back propagation of errors. In addition, a comparison of serial and batch modes of learning for multilayer artificial neural network.

Ключевые слова: нейронная сеть, пакетный режим обучения, последовательный режим обучения, обучение нейронных сетей, метод обратного распространения ошибок.

Keywords: neural network, batch training, sequential learning mode, learning neural networks, back-propagation method errors.

Искусственный интеллект – это одно из развивающихся направлений науки, которое в последнее время получает все большее признание. К искусственному интеллекту относятся такие области науки как нейронные сети, Data mining, Big Data, генетические алгоритмы, онтология, распознавание образов и т. д.

Искусственные нейронные сети представляют собой технологию, которая включает следующие области науки: нейрофизиология, статистика, математика [1; 3; 5]. Искусственные нейронные сети имитируют работу нейронов мозга, и способность обрабатывать информацию за минимальное время. Искусственные нейронные сети бывают двух видов: однослойные и многослойные [2; 4].

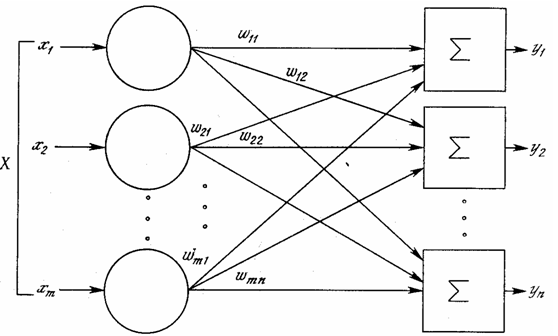

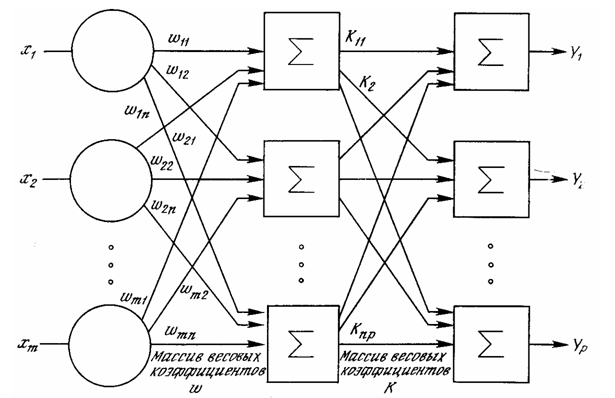

Примеры однослойной и многослойной структуры нейронной сети представлены на рисунке 1 и на рисунке 2.

Рисунок 1. Однослойная нейронная сеть

Рисунок 2. Многослойная нейронная сеть

Как следует из рисунков, разница между однослойной и многослойной нейронной сетью в количестве вычислительных нейронных слоев. Естественно, чем больше вычислительных нейронов, тем больше вычислительная мощность нейронной сети. Кроме существенной вычислительной мощности, нейронная сеть также обладает способностью к обучению [6; 7; 8]. Обучение является одним из самых важных качеств нейронных сетей. Существует огромное разнообразие алгоритмов обучения, которые строятся на обучении с учителем или без учителя. Обучение с учителем – это обучение, при котором на вход нейронных сетей поступают образы, которые нейронная сеть усваивает и после этого действует по определенному алгоритму [9; 11]. Обучение без учителя – это обучение, при котором сеть самостоятельно настраивает веса по определенному алгоритму.

Рассмотрим алгоритм обратного распространения для обучения многослойной нейронной сети. В данном алгоритме сигнал ошибки выходного нейрона j (j – номер нейрона) на итерации n (соответствует n-му примеру обучения) определяется соотношением ej(n) = dj(n) – yj(n). Текущее значение энергии ошибки нейрона j определим как  . Соответственно текущее значение Е(n) общей энергии ошибки сети вычисляется путем сложения величин

. Соответственно текущее значение Е(n) общей энергии ошибки сети вычисляется путем сложения величин  по всем нейронам выходного слоя. Следовательно, формулу можно представить как Е(n) =

по всем нейронам выходного слоя. Следовательно, формулу можно представить как Е(n) =  [12]. Пусть N – общее число образов в обучающем множестве. Данное значение энергии является функцией всех свободных нейронов, также, как и средняя энергия ошибки Eav. Для данного обучения средняя энергия ошибки Eav является функцией стоимости – мера эффективности обучения. Целью обучения является настройка параметров нейронной сети с целью минимизации средней энергии ошибки Eav в обучении. Настройка весов выполняется в соответствии с ошибками, которые вычисляются для каждого образа, представленного в сети [3; 6]. Арифметическое среднее отдельных изменений для весов сети по обучающему множеству может служить оценкой реальных изменений, которые произошли в процессе минимизации функции стоимости. Алгоритм сталкивается с большими трудностями, если нейрон j является скрытым (расположен в скрытом слое сети), то желаемый отклик для него неизвестен. При использовании алгоритма обратного распространения различают два подхода, выполняемых в процессе вычислений. Первый подход называется прямым, второй – обратным. При использовании прямого прохода синаптические веса не изменяются, а функциональные сигналы вычисляются последовательно по формуле: yi(n) = φ (vi(n)), где vi(n) – локальное поле нейрона. Обратный проход начинается с выходного слоя предъявлением ему сигнала ошибки, который предается справа налево с вычислением локального градиента для каждого нейрона [4; 5]. Для нейрона, находящегося во входном поле, градиент равен соответствующему сигналу ошибки, умноженному на производную нелинейной функции активации. Зная все градиенты локального поля, можно вычислить градиенты предыдущего поля. Таким образом, происходит коррекция всех синаптических связей в нейронной сети для всех слоев в обратном направлении. Также следует отметить, что после очередного образа фиксируются значения синаптических весов. Данный алгоритм используется для построения в пространстве весов, которые вычисляются методом наискорейшего спуска [7; 9]. Суть данного метода состоит в том, что чем меньше параметр скорости обучения нейронной сети, тем меньше корректировка синаптических весов, и, следовательно, тем более гладкая траектория. Такой метод при больших изменениях может привести к неустойчивому состоянию системы.

[12]. Пусть N – общее число образов в обучающем множестве. Данное значение энергии является функцией всех свободных нейронов, также, как и средняя энергия ошибки Eav. Для данного обучения средняя энергия ошибки Eav является функцией стоимости – мера эффективности обучения. Целью обучения является настройка параметров нейронной сети с целью минимизации средней энергии ошибки Eav в обучении. Настройка весов выполняется в соответствии с ошибками, которые вычисляются для каждого образа, представленного в сети [3; 6]. Арифметическое среднее отдельных изменений для весов сети по обучающему множеству может служить оценкой реальных изменений, которые произошли в процессе минимизации функции стоимости. Алгоритм сталкивается с большими трудностями, если нейрон j является скрытым (расположен в скрытом слое сети), то желаемый отклик для него неизвестен. При использовании алгоритма обратного распространения различают два подхода, выполняемых в процессе вычислений. Первый подход называется прямым, второй – обратным. При использовании прямого прохода синаптические веса не изменяются, а функциональные сигналы вычисляются последовательно по формуле: yi(n) = φ (vi(n)), где vi(n) – локальное поле нейрона. Обратный проход начинается с выходного слоя предъявлением ему сигнала ошибки, который предается справа налево с вычислением локального градиента для каждого нейрона [4; 5]. Для нейрона, находящегося во входном поле, градиент равен соответствующему сигналу ошибки, умноженному на производную нелинейной функции активации. Зная все градиенты локального поля, можно вычислить градиенты предыдущего поля. Таким образом, происходит коррекция всех синаптических связей в нейронной сети для всех слоев в обратном направлении. Также следует отметить, что после очередного образа фиксируются значения синаптических весов. Данный алгоритм используется для построения в пространстве весов, которые вычисляются методом наискорейшего спуска [7; 9]. Суть данного метода состоит в том, что чем меньше параметр скорости обучения нейронной сети, тем меньше корректировка синаптических весов, и, следовательно, тем более гладкая траектория. Такой метод при больших изменениях может привести к неустойчивому состоянию системы.

Также для многослойной нейронной сети есть последовательный и пакетный режим обучения. Последовательный режим обучения по методу обратного распространения называют стохастическим или интерактивным. В этом режиме корректировка весов проводится после каждого примера. В методе проводится корректировка последовательно для каждого примера, то есть если у нас есть N обучающих примеров, то в сети проходит корректировка методам прямого и обратного распространения, так происходит пока все примеры не пройдут все эпохи (эпохой называется полный цикл предъявления полного набора примеров обучения) [10; 12].

Пакетный режим обучения по методу обратного распространения проводится после подачи в сеть примеров обучения, при этом идет распределение и корректировка весов. Для процессов реального времени последовательный режим является более предпочтительным, чем пакетный, потому что требует меньшего объема памяти для хранения синаптических связей. Поиск по весам в таком методе можно делать стохастическим. Такой поиск сократит возможность остановки алгоритма до минимального значения. Но следует отметить, что стахостический последовательный режим сложен для нахождения сходимостей, тогда как пакетный режим обеспечивает оценку вектора градиента. Также большим плюсом пакетного режима является то, что легче реализуются параллельные вычисления, но с другой стороны, если данные обучения являются избыточными, то последовательный режим предпочтительнее, так как повторяющиеся образы будут одинаковыми, что увеличит скорость обучения.

Скрытые нейроны являются важными для многослойных нейронных сетей, поскольку они выполняют роль детекторов признаков. В ходе обучения скрытые нейроны определяют характерные черты данных обучения. Это осуществляется с помощью нелинейного преобразования входных данных в скрытое пространство или пространство признаков. В зависимости от задачи данное пространство используется для облегчения отделения признаков по сравнению с исходным пространством. Таким образом, если бы перед нами стояла задача кластеризации, то в пространстве признаков находились бы классы, которые отделить друг от друга в пространстве классов легче, чем в неструктурированном пространстве [7; 9].

Многослойная нейронная сеть, обучаемая алгоритму обратного распространения, можно рассматривать, как механизм реализации нелинейного отображения «вход-выход» общего вида. Например, пусть m0 – это количество входных узлов многослойной нейронной сети, тогда M= mL – количество нейронов выходного слоя сети. Отношения «вход-выход» для такой сети отображает m0 – мерное Евклидово пространство входных данных в М – мерное Евклидово пространство выходных сигналов, которое непрерывно дифференцируется бесконечное число раз.

При решении реальных задач с помощью нейронных сетей обычно требуется использовать нейронные сети, которые четко структурированы и имеют большой размер, следовательно, и большую вычислительную мощность. Конечно, встает вопрос о минимизации размера сети без потерь мощности и производительности. Но при уменьшении размера нейронной сети снижается вероятность обучения помехам [3; 6; 8]. Для минимизации искусственной нейронной сети можно использовать два способа:

- Наращивание сети. В данном способе в начале создается простая многослойная нейронная сеть. Если у сети не хватает мощности, то создается нейрон, или слой скрытых нейронов, которые создаются только, если в процессе обучения ошибка перестает уменьшаться [5; 8].

- Упрощение структуры сети. Данный подход обратен первому. То есть, создается большая многослойная нейронная сеть, а после этого с каждым шагом упрощается структура [2; 7].

В упрощении структуры сети есть два основных подхода: первый – регуляризация, а второй – удаление из сети синаптических связей [3].

Регуляризация сложности использует модель, на основе которой строится сеть. Поскольку архитектура любой нейронной сети статична, то ставится задача обеспечения баланса между достоверностью данных обучения и качеством модели. Регуляризация сложности в нейронной сети достигается с помощью минимизации общего риска: R(w) = Es(w)+ lEc(w), где Es(w) – это стандартная мера эффективности (данная переменная зависит как от модели, так и от входных данных), Ec(w) – штраф за сложность (зависит только от самой модели), l – является параметром регуляризации. Если параметр l равен нулю, то нейронная сеть соответствует требуемому уровню архитектуры для решения поставленной задачи. Если наоборот является слишком большим значением, то ставится усредненное значение. Одной из ярких процедур по изменению архитектуры является снижение весов. В данной процедуре слагаемое штрафа за сложность определяется как квадрат нормы вектора весовых коэффициентов w (всех свободных параметров) [12]. Таким образом, веса в сети разбиваются на две группы: веса, которые имеют огромное влияние на сеть и веса, которые имеют малое влияние на сеть. Синаптические веса, которые имеют огромное влияние, называются избыточными. Без регуляции сложности эти веса приводят к изменению качества нейронной сети. В данной процедуре ко всем слоям нейронной сети применяется один и тот же подход, пространство весов находится в начале координат [10; 11].

Список литературы:

- Барский А.Б. Нейронные сети: распознавание, управление, принятие решений. – М.: Финансы и статистика, 2004. – 176 с.

- Каллан Роберт. Основные концепции нейронных сетей: Пер. с англ. – М.: Издательский дом «Вильямс», 2001.

- Комарцова Л.Г., Максимов А.В. Нейрокомпьютеры: Учеб. пособие для вузов. – 2-е изд., перераб. и доп. – М.: Изд-во МГТУ им. Н.Э. Баумана, 2004. – 400 с.

- Мелихова О.А., Чумичев В.С., Джамбинов С.В., Гайдуков А.Б. Некоторые аспекты криптографического взлома и повышения надежности алгоритмов шифрования // Молодой ученный. – Казань, № 11 (91), 2015. – С. 392–394.

- Мелихова О.А. Приложение матлогики к проблемам моделирования // Известия ЮФУ. Технические науки. – Таганрог: Изд-во ТТИ ЮФУ, 2014. № 7 (156). – С. 204–214.

- Мелихова О.А., Гайдуков А.Б., Джамбинов С.В., Чумичев В.С., Григораш А.С. Алгоритмы шифрования: LUCIFER, NEWDES, BLOWFISH, KHUFU, KHAFRE // Актуальные проблемы гуманитарных и естественных наук. – Москва, № 07 (78). Ч. 1. 2015. – С. 64–67.

- Мелихова О.А., Гайдуков А.Б., Джамбинов С.В., Чумичев В.С. Методы поддержки принятия решений на основе нейронных сетей // Актуальные проблемы гуманитарных и естественных наук. – Москва, № 09 (80). Ч. 1. 2015. – С. 52–59.

- Мелихова О.А., Григораш А.С., Джамбинов С.В., Чумичев В.С., Гайдуков А.Б. Некоторые аспекты теории нейронных систем // Молодой ученый. – Казань. № 16 (96), 2015. – С. 196–199.

- Мелихова О.А., Григораш А.С., Джмбинов С.В, Чумичев В.С, Гайдуков А.Б. Методы обучения в системах искусственного интеллекта // Технические науки – от теории к практике / Сб. ст. по материалам LII междунар. науч.-практ. конф № 11 (47). Новосибирск: Изд. АНС «Сибак», 2015 – С. 19–29.

- Осовский С. Нейронные сети для обработки информации / Пер. с польского И.Д. Рудинского. – М.: Финансы и статистика, 2002. – 344 с.

- Рутковская Д., Пилиньский М., Рутковский Л. Нейронные сети, генетические алгоритмы и нечеткие системы: Пер. с польск. И.Д. Рудинского – М.: Горячая линия – Телеком, 2006 – 452 с.

- Уоссермен Ф. Нейрокомпьютерная техника: Теория и практика. – М.: Мир, 1992 – 184 с.

дипломов